Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

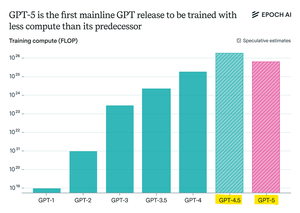

Epoch Research утверждает:

GPT-5 использовал меньше вычислительных ресурсов для предварительного обучения, чем GPT-4.5, но, вероятно, GPT-6 будет обучен с использованием большего объема ресурсов.

Это связано с тем, что улучшения "рассуждения" после обучения замедляются,

и с учетом доступности более крупных кластеров GPU, масштабирование предварительного обучения снова имеет смысл.

Модель max-compute от openAI + RL будет безумной.

Топ

Рейтинг

Избранное