Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

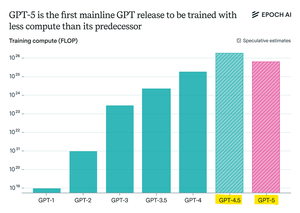

Epoch Research beweert:

GPT-5 gebruikte minder pre-training rekencapaciteit dan GPT-4.5, maar GPT-6 zal waarschijnlijk weer op meer worden getraind.

Dat komt omdat de "redenering" verbeteringen na de training aan het afnemen zijn,

en met grotere GPU-clusters beschikbaar, is het weer logisch om de pre-training op te schalen.

openAI max-rekenmodel + RL zal insane zijn.

Boven

Positie

Favorieten