Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

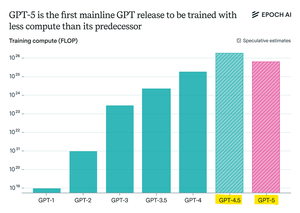

Epoch Research tvrdí:

GPT-5 spotřeboval méně předtrénovacích výpočtů než GPT-4.5, ale GPT-6 bude pravděpodobně opět trénován na více

je to proto, že "uvažování" o zlepšení po tréninku se zpomaluje,

a s většími dostupnými clustery GPU má škálování předběžného trénování opět smysl.

openAI max-compute model + RL bude šílené

Top

Hodnocení

Oblíbené