Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

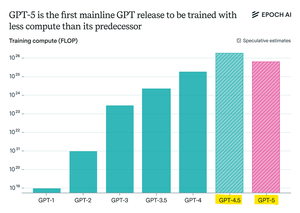

Epoch Research afirma:

GPT-5 usó menos computación previa al entrenamiento que GPT-4.5, pero es probable que GPT-6 vuelva a entrenarse más

Eso es porque las mejoras posteriores al entrenamiento de "razonamiento" se están ralentizando,

y con clústeres de GPU más grandes disponibles, escalar el preentrenamiento vuelve a tener sentido.

El modelo de cómputo máximo de openAI + RL será una locura

Populares

Ranking

Favoritas