Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

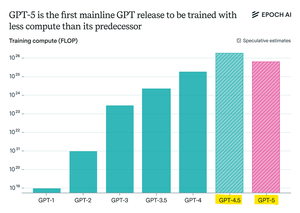

Epoch Research hevder:

GPT-5 brukte mindre beregning før trening enn GPT-4.5, men GPT-6 vil sannsynligvis bli trent på mer igjen

Det er fordi "resonnement" forbedringer etter trening bremser opp,

og med større GPU-klynger tilgjengelig, er skalering av forhåndsopplæring fornuftig igjen.

openAI max-compute model + RL vil være gal

Topp

Rangering

Favoritter