トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

エポック・リサーチは次のように主張している。

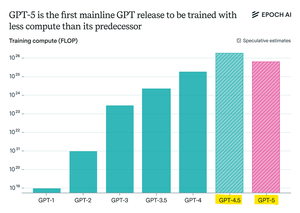

GPT-5 は GPT-4.5 よりも事前トレーニング コンピューティングの使用量が少なかったが、GPT-6 は再びより多くのトレーニングを受ける可能性が高い

それは、トレーニング後の「推論」の改善が遅くなっているためです。

また、より大きな GPU クラスターが利用可能になったため、事前トレーニングのスケーリングが再び理にかなっています。

openAI max-computeモデル+RLは非常識になるだろう

トップ

ランキング

お気に入り