Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

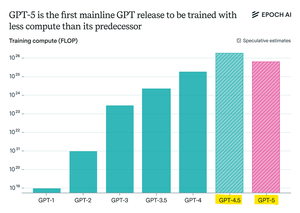

Epoch Research afferma:

GPT-5 ha utilizzato meno risorse di pre-addestramento rispetto a GPT-4.5, ma è probabile che GPT-6 venga addestrato su più risorse di nuovo.

Questo perché i miglioramenti nel "ragionamento" post-addestramento stanno rallentando,

e con cluster GPU più grandi disponibili, ha senso scalare nuovamente il pre-addestramento.

Il modello max-compute di openAI + RL sarà pazzesco.

Principali

Ranking

Preferiti