Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

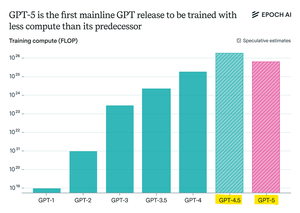

Epoch Research susține:

GPT-5 a folosit mai puțin calcul de pre-antrenament decât GPT-4.5, dar GPT-6 va fi probabil antrenat din nou pe mai mult

asta pentru că îmbunătățirile post-antrenament încetinesc,

și cu clustere GPU mai mari disponibile, scalarea pre-antrenamentului are din nou sens.

openAI max-compute model + RL va fi o nebunie

Limită superioară

Clasament

Favorite