Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

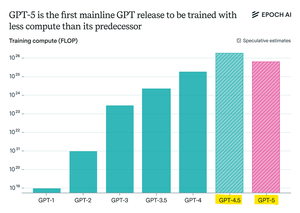

Nghiên cứu Epoch tuyên bố:

GPT-5 sử dụng ít tài nguyên tính toán tiền huấn luyện hơn so với GPT-4.5, nhưng GPT-6 có khả năng sẽ được huấn luyện với nhiều tài nguyên hơn nữa.

Điều đó là vì những cải tiến "lập luận" sau huấn luyện đang chậm lại,

và với các cụm GPU lớn hơn có sẵn, việc mở rộng tiền huấn luyện lại trở nên hợp lý.

Mô hình tính toán tối đa của openAI + RL sẽ thật điên rồ.

Hàng đầu

Thứ hạng

Yêu thích