Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

A Epoch Research afirma:

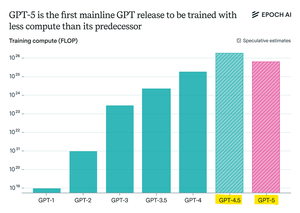

O GPT-5 usou menos computação pré-treinamento do que o GPT-4.5, mas o GPT-6 provavelmente será treinado em mais novamente

isso porque as melhorias pós-treinamento de "raciocínio" estão diminuindo,

e com clusters de GPU maiores disponíveis, o dimensionamento do pré-treinamento faz sentido novamente.

modelo de computação máxima openAI + RL será insano

Melhores

Classificação

Favoritos