Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

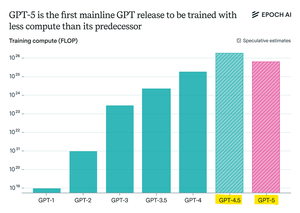

Epoch Research behauptet:

GPT-5 hat weniger Vortrainings-Rechenleistung verwendet als GPT-4.5, aber GPT-6 wird wahrscheinlich wieder mit mehr trainiert werden.

Das liegt daran, dass die "Reasoning"-Verbesserungen nach dem Training langsamer werden,

und mit größeren GPU-Clustern, die verfügbar sind, macht es wieder Sinn, das Vortraining zu skalieren.

Das max-compute Modell von openAI + RL wird verrückt sein.

Top

Ranking

Favoriten