Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

AI bryter datastabelen.

De fleste bedrifter har brukt det siste tiåret på å bygge sofistikerte datastabler. ETL-pipeliner flytter data til lagre. Transformasjonslag renser data for analyse. BI-verktøy viser innsikt til brukere.

Denne arkitekturen fungerte for tradisjonell analyse.

Men AI krever noe annet. Den trenger kontinuerlige tilbakemeldingssløyfer. Det krever innebygging i sanntid og gjenfinning av kontekst.

Tenk på en kunde i en minibank som tar ut lommepenger. AI-agenten på mobilappen deres trenger å vite om den $40-transaksjonen i løpet av sekunder. Datanøyaktighet og hastighet er ikke valgfritt.

Netflix gjenoppbygde hele anbefalingsinfrastrukturen for å støtte modelloppdateringer i sanntid1. Stripe opprettet enhetlige pipeliner der betalingsdata flyter inn i svindelmodeller i løpet av millisekunder2.

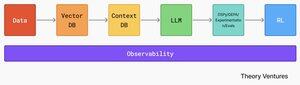

Den moderne AI-stabelen krever en fundamentalt annerledes arkitektur. Data flyter fra ulike systemer til vektordatabaser, der innebygginger og høydimensjonale data lever sammen med tradisjonelle strukturerte data. Kontekstdatabaser lagrer den institusjonelle kunnskapen som informerer AI-beslutninger.

AI-systemer bruker disse dataene, og går deretter inn i eksperimenteringssløyfer. GEPA og DSPy muliggjør evolusjonær optimalisering på tvers av flere kvalitetsdimensjoner. Evalueringer måler ytelse. Forsterkende læring lærer opp agenter til å navigere i komplekse bedriftsmiljøer.

Til grunn for alt ligger et observerbarhetslag. Hele systemet trenger nøyaktige data og raskt. Det er derfor dataobserverbarhet også vil smelte sammen med AI-observerbarhet for å gi dataingeniører og AI-ingeniører ende-til-ende-forståelse av helsen til rørledningene deres.

Data- og AI-infrastruktur konvergerer ikke. De har allerede smeltet sammen.

Referanser

Netflix teknologiblogg. (2025, august). "Fra fakta og beregninger til mediemaskinlæring: Utvikling av dataingeniørfunksjonen hos Netflix." ↩︎

Stripe. (2025). "Hvordan vi bygde det: Stripe Radar." ↩︎

Topp

Rangering

Favoritter