Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

AI merusak tumpukan data.

Sebagian besar perusahaan menghabiskan dekade terakhir untuk membangun tumpukan data yang canggih. Alur ETL memindahkan data ke gudang. Lapisan transformasi membersihkan data untuk analitik. Alat BI menampilkan wawasan kepada pengguna.

Arsitektur ini berfungsi untuk analitik tradisional.

Tetapi AI menuntut sesuatu yang berbeda. Itu membutuhkan loop umpan balik yang berkelanjutan. Ini membutuhkan penyematan real-time & pengambilan konteks.

Pertimbangkan pelanggan di ATM yang menarik uang saku. Agen AI di aplikasi seluler mereka perlu mengetahui tentang transaksi $40 itu dalam hitungan detik. Akurasi & kecepatan data bukanlah opsional.

Netflix membangun kembali seluruh infrastruktur rekomendasi mereka untuk mendukung pembaruan model real-time1. Stripe menciptakan pipeline terpadu tempat data pembayaran mengalir ke model penipuan dalam milidetik2.

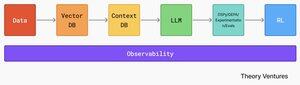

Tumpukan AI modern membutuhkan arsitektur yang berbeda secara fundamental. Data mengalir dari beragam sistem ke dalam database vektor, di mana penyematan & data dimensi tinggi hidup bersama data terstruktur tradisional. Basis data konteks menyimpan pengetahuan kelembagaan yang menginformasikan keputusan AI.

Sistem AI mengonsumsi data ini, lalu memasuki loop eksperimen. GEPA & DSPy memungkinkan pengoptimalan evolusioner di berbagai dimensi kualitas. Evaluasi mengukur kinerja. Pembelajaran penguatan melatih agen untuk menavigasi lingkungan perusahaan yang kompleks.

Mendasari semuanya adalah lapisan observabilitas. Seluruh sistem membutuhkan data yang akurat & cepat. Itu sebabnya observabilitas data juga akan menyatu dengan observabilitas AI untuk memberikan insinyur data & insinyur AI pemahaman menyeluruh tentang kesehatan saluran mereka.

Infrastruktur data & AI tidak konvergen. Mereka sudah menyatu.

Referensi

Blog Teknologi Netflix. (2025, Agustus). "Dari Fakta & Metrik hingga Pembelajaran Mesin Media: Mengembangkan Fungsi Rekayasa Data di Netflix." ↩︎

Stripe. (2025). "Bagaimana Kami Membangunnya: Radar Garis." ↩︎

Teratas

Peringkat

Favorit