Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

Hver porteføljeforvalter kjenner den effektive grensen - settet med optimale porteføljer som gir maksimal avkastning for gitte risikonivåer. Hva om AI-forespørsler hadde sin egen effektive grense?

Når vi alle begynner å bruke AI, vil rask optimalisering være en konsekvent utfordring. GEPA, GEnerative PAreto, er en teknikk for å oppdage den tilsvarende effektive grensen for AI.

Da jeg leste artikkelen, la jeg merke til at de første resultatene var lovende, med en forbedring på 10 poeng på visse benchmarks og en 9,2 ganger kortere promptlengde. Kortere ledetekstlengde, og vi vet alle at inndataforespørsler er den største kostnadsdriveren (se The Hungry, Hungry AI Model). Så jeg implementerte GEPA i EvoBlog.

For å bruke GEPA må vi identifisere poengaksene som en LLM bruker for å score et innlegg. Her er mine: (første bilde)

Nå som vi har dette rammeverket, kan vi legge inn en melding om å generere et blogginnlegg og få EvoBlog-systemet til å iterere gjennom forskjellige ledetekster for å møte den effektive grensen for hver dimensjon, vektet på tvers av alle variabler – ikke bare én.

Her er poengsummene for to hypotetiske blogginnlegg. Du kan se at den ene topper mer på stil, mens den andre fokuserer på databruk. Ved å bruke GEPA kan vi finne ut hvilken som er den beste allsidige stolpen. I dette tilfellet er det det datafokuserte innlegget.

Alt dette for å si, kjære leser, at jeg bare har publisert ett blogginnlegg fullt generert av AI.

Målet mitt med disse automatiserte systemene er å lære hvordan de fungerer, hvordan du justerer dem, og genererer innledende utkast som tilnærmer meg mine første og andre utkast. Jeg vil alltid fullføre utkast tre og fire.

Den effektive grensen er ingen erstatning for innsikt og en autentisk stemme.

2,59K

Hvor lenge og hvor raskt kan en virksomhet sammensettes?

Dette er et spørsmål hver investor stiller til enhver virksomhet, offentlig eller privat.

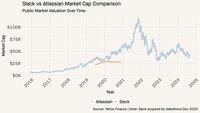

På 2010-tallet ble Slack & Atlassian titaner. Den dagen Salesforce kunngjorde sin intensjon om å kjøpe Slack, var det like verdifullt for Atlassian til ~27 milliarder dollar.

Inntektskurvene ser like ut i de siste årene, lignende vekstrater. Atlassian fortsetter å forbindes i massiv skala.

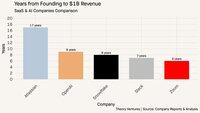

Men tiden for å oppnå 1 milliard dollar fra grunnleggelsesdatoen varierer med et tiår: 17 mot 7 år.

For å skape verdier må en oppstart vokse raskt og vokse i stor skala; eller vokse konsekvent over lang tid. AI-selskaper i dag vokser veldig raskt. T3D2-selskapene kan vokse langsommere over lengre tid for å oppnå samme markedsverdi.

Sammenlign OpenAIs 400 % vekst på 1 milliard dollar med Atlassians 30 %. Eller snøfnugg på 124 %. Snowflake er markedsverdi på 75 milliarder dollar i dag, Atlassian 42 milliarder dollar. Fordelen med et damphode er klar.

3,3K

Topp

Rangering

Favoritter