Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Análise independente de modelos de IA e provedores de hospedagem - escolha o melhor modelo e provedor de API para seu caso de uso

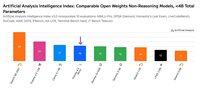

A versão atualizada do GLM 4.6 (Raciocínio) da Z ai é um dos modelos de pesos abertos mais inteligentes, com inteligência próxima ao nível do DeepSeek V3.1 (Raciocínio) e Qwen3 235B 2507 (Raciocínio)

🧠 Principais conclusões sobre a avaliação de inteligência:

➤ Desempenho do Modelo de Raciocínio: O GLM 4.6 (Raciocínio) pontua 56 no Índice de Inteligência de Análise Artificial, subindo do score de 51 do GLM 4.5 em modo de raciocínio

➤ Desempenho do Modelo Não-Raciocínio: Em modo não-raciocínio, o GLM 4.6 alcança uma pontuação de 45, colocando-o 2 pontos à frente do GPT-5 (mínimo, não-raciocínio)

➤ Eficiência de Tokens: A Z ai aumentou as pontuações de avaliação do GLM enquanto diminuiu os tokens de saída. Para o GLM 4.6 (Raciocínio), vemos uma diminuição material de 14% no uso de tokens para executar o Índice de Inteligência de Análise Artificial, passando de 100M para 86M, em comparação com o GLM 4.5 (Raciocínio). Isso é diferente de outras atualizações de modelos que vimos, onde o aumento da inteligência está frequentemente correlacionado com o aumento no uso de tokens de saída. Em modo não-raciocínio, o GLM 4.6 usa 12M de tokens de saída para o Índice de Inteligência de Análise Artificial

Outros detalhes do modelo:

➤🪙 Janela de Contexto: 200K tokens de contexto. Isso é maior em comparação com a janela de contexto de 128K tokens do GLM 4.5

➤📏 Tamanho: O GLM 4.6 possui 355B de parâmetros totais e 32B de parâmetros ativos - isso é o mesmo que o GLM 4.5. Para autoimplantação, o GLM 4.6 exigirá ~710GB de memória para armazenar os pesos na precisão nativa BF16 e não pode ser implantado em um único nó NVIDIA 8xH100 (~640GB de memória)

➤©️ Licenciamento: O GLM 4.6 está disponível sob a Licença MIT

➤🌐 Disponibilidade: O GLM 4.6 está disponível na API de primeira linha da Z ai e em várias APIs de terceiros, como DeepInfra (FP8), Novita (BF16), GMI Cloud (BF16) e Parasail (FP8)

8,8K

A IBM lançou o Granite 4.0 - uma nova família de modelos de linguagem de pesos abertos variando em tamanho de 3B a 32B. A Artificial Analysis teve acesso pré-lançamento, e nossos testes mostram que o Granite 4.0 H Small (32B/9B parâmetros totais/ativos) obteve um Índice de Inteligência de 23, com uma força particular na eficiência de tokens.

Hoje, a IBM lançou quatro novos modelos: Granite 4.0 H Small (32B/9B parâmetros totais/ativos), Granite 4.0 H Tiny (7B/1B), Granite 4.0 H Micro (3B/3B) e Granite 4.0 Micro (3B/3B). Avaliamos o Granite 4.0 Small (em modo não-raciocínio) e o Granite 4.0 Micro usando o Índice de Inteligência da Artificial Analysis. Os modelos Granite 4.0 combinam uma pequena quantidade de camadas de atenção estilo transformer padrão com a maioria das camadas Mamba, que afirmam reduzir os requisitos de memória sem impactar o desempenho.

Principais conclusões dos testes:

➤🧠 Inteligência do Granite 4.0 H Small: Em modo não-raciocínio, o Granite 4.0 H Small pontua 23 no índice de Inteligência da Artificial Analysis - um salto de +8 pontos no Índice em comparação com o IBM Granite 3.3 8B (Não Raciocínio). O Granite 4.0 H Small fica à frente do Gemma 3 27B (22), mas atrás do Mistral Small 3.2 (29), EXAONE 4.0 32B (Não-Raciocínio, 30) e Qwen3 30B A3B 2507 (Não-Raciocínio, 37) em inteligência.

➤⚡ Inteligência do Granite 4.0 Micro: No Índice de Inteligência da Artificial Analysis, o Granite 4.0 Micro pontua 16. Ele fica à frente do Gemma 3 4B (15) e LFM 2 2.6B (12).

➤⚙️ Eficiência de tokens: O Granite 4.0 H Small e Micro demonstram uma impressionante eficiência de tokens - o Granite 4.0 Small usa 5.2M, enquanto o Granite 4.0 Micro usa 6.7M tokens para executar o Índice de Inteligência da Artificial Analysis. Ambos os modelos usam menos tokens do que o Granite 3.3 8B (Não-Raciocínio) e a maioria dos outros modelos de pesos abertos não-raciocínio menores que 40B parâmetros totais (exceto Qwen3 0.6B que usa 1.9M tokens de saída).

Detalhes principais do modelo:

➤🌐 Disponibilidade: Todos os quatro modelos estão disponíveis no Hugging Face. O Granite 4.0 H Small está disponível no Replicate e é precificado em $0.06/$0.25 por 1M de tokens de entrada/saída.

➤📏 Janela de Contexto: 128K tokens.

➤©️ Licenciamento: Os modelos Granite 4.0 estão disponíveis sob a licença Apache 2.0.

35,8K

A DeepSeek lançou a V3.2 Exp com a sua nova arquitetura DeepSeek Sparse Attention (DSA), que afirma reduzir o impacto da escalabilidade quadrática do cálculo com o comprimento do contexto.

Testámos de forma independente a V3.2 Exp, que alcançou uma inteligência semelhante à DeepSeek V3.1 Terminus; a DeepSeek passou a usar a V3.2 para o seu endpoint principal da API e reduziu os preços da API em mais de 50%. Com a atualização dos preços da API de primeira parte da DeepSeek, o custo para executar o Índice de Inteligência de Análise Artificial cai de $114 para $41.

A DeepSeek afirma ter "alinhado deliberadamente" as configurações de treinamento da V3.1 Terminus e da V3.2 Exp. Igualar o desempenho da V3.1 Terminus parece demonstrar que os benefícios de desempenho da arquitetura DeepSeek Spare Attention não vêm à custa da inteligência.

Principais conclusões dos benchmarks:

➤🧠 Sem alteração na inteligência agregada: No modo de raciocínio, a DeepSeek V3.2 Exp pontua 57 no Índice de Inteligência de Análise Artificial. Vemos isso como equivalente em inteligência à DeepSeek V3.1 Terminus (Raciocínio)

➤📈 Sem declínio no raciocínio de longo contexto: Apesar das mudanças na arquitetura da DeepSeek, a V3.2 Exp (Raciocínio) parece não apresentar qualquer declínio no raciocínio de longo contexto - pontuando um leve aumento no AA-LCR.

➤⚡ Desempenho não relacionado ao raciocínio: No modo não relacionado ao raciocínio, a DeepSeek V3.2 Exp não mostra degradação na inteligência, igualando a DeepSeek V3.1 Terminus com uma pontuação de 46 no Índice de Inteligência de Análise Artificial.

➤⚙️ Eficiência de tokens: Para a DeepSeek V3.2 Exp (Raciocínio), o uso de tokens para executar o Índice de Inteligência de Análise Artificial diminui ligeiramente de 67M para 62M em comparação com a V3.1 Terminus. O uso de tokens permanece inalterado para a variante não relacionada ao raciocínio.

➤💲Preços: A DeepSeek reduziu significativamente o preço por token para a sua API de primeira parte de $0.56/$1.68 para $0.28/$0.42 por 1M de tokens de entrada/saída - uma redução de 50% e 75% nos preços dos tokens de entrada e saída, respetivamente.

Outros detalhes do modelo:

➤©️ Licenciamento: A DeepSeek V3.2 Exp está disponível sob a Licença MIT.

➤🌐 Disponibilidade: A DeepSeek V3.2 Exp está disponível via API DeepSeek, que substituiu a DeepSeek V3.1 Terminus. Os usuários ainda podem acessar a DeepSeek V3.1 Terminus através de uma API DeepSeek temporária até 15 de outubro.

➤📏 Tamanho: A DeepSeek V3.2 Exp tem 671B de parâmetros totais e 37B de parâmetros ativos. Isso é o mesmo que todos os modelos anteriores nas séries DeepSeek V3 e R1.

41,38K

Top

Classificação

Favoritos