Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

La plupart des évaluations d'IA sont des mensonges coûteux.

Elles mesurent généralement ce qui est facile à mesurer—des métriques comme "hallucination" et "toxicité"—et non les manières spécifiques dont votre produit échoue réellement aux utilisateurs.

@HamelHusain et @sh_reya enseignent une approche différente—celle qui a fait de leur cours le plus rentable sur @MavenHQ, avec une inscription constante de @OpenAI, @AnthropicAI et de tous les grands laboratoires d'IA.

Leur idée : Commencez par l'analyse des erreurs, pas par les métriques.

Examinez 100 interactions réelles avec des utilisateurs. Rédigez des critiques détaillées de ce qui a réellement mal tourné. Trouvez des motifs. Ce n'est qu'ensuite que vous construisez des évaluations qui améliorent votre produit.

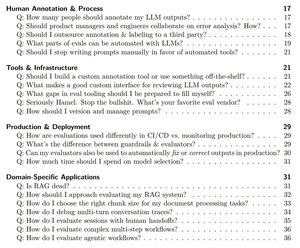

Après avoir formé plus de 2 000 PM et ingénieurs dans plus de 500 entreprises, ils ont distillé leur méthodologie dans un manuel systématique qui vous montre exactement comment :

- Identifier les ~10 modes de défaillance qui brisent réellement votre produit

- Construire des juges LLM que vous pouvez valider statistiquement et en qui vous pouvez avoir confiance

- Créer des pipelines CI/CD qui détectent les régressions avant que les utilisateurs ne le fassent

- Transformer la surveillance de la production en un moteur de découverte pour de nouveaux problèmes

Lisez leur guide complet ici :

Meilleurs

Classement

Favoris