Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Більшість штучного інтелекту – це дорога брехня.

Зазвичай вони вимірюють те, що легко виміряти – такі показники, як «галюцинації» та «токсичність», — а не конкретні способи, якими ваш продукт насправді підводить користувачів.

@HamelHusain і @sh_reya викладають інший підхід, який зробив їхній курс #1 найкасовішим у @MavenHQ, з постійним набором від @OpenAI, @AnthropicAI та кожної великої лабораторії штучного інтелекту.

Їхня думка: почніть з аналізу помилок, а не з показників.

Перегляньте 100 реальних взаємодій користувачів. Напишіть детальну критику того, що насправді пішло не так. Знаходьте закономірності. Тільки після цього створюйте евали, які зроблять ваш продукт кращим.

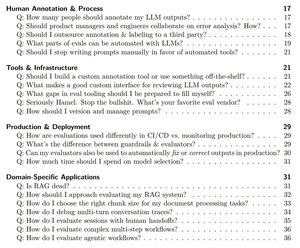

Навчивши 2 000+ PM та інженерів у 500+ компаніях, вони перетворили свою методологію на систематичний посібник, який покаже вам, як саме:

- Визначте ~10 режимів збоїв, які насправді ламають ваш продукт

- Створюйте суддів LLM, яких ви можете статистично перевірити та довіряти

- Створюйте пайплайни CI/CD, які вловлюють регресії раніше, ніж це зроблять користувачі

- Перетворіть моніторинг виробництва на двигун виявлення нових проблем

Прочитайте їх повний посібник тут:

Найкращі

Рейтинг

Вибране