Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

La mayoría de las evaluaciones de IA son mentiras caras.

Por lo general, miden lo que es fácil de medir, métricas como "alucinación" y "toxicidad", no las formas específicas en que su producto realmente falla a los usuarios.

@HamelHusain y @sh_reya enseñan un enfoque diferente, uno que ha convertido a su curso en el # 1 más taquillero de @MavenHQ, con una inscripción constante de @OpenAI, @AnthropicAI y todos los principales laboratorios de IA.

Su idea: comience con el análisis de errores, no con las métricas.

Revise 100 interacciones reales de usuarios. Escribe críticas detalladas de lo que realmente salió mal. Encuentra patrones. Solo entonces construya evaluaciones que mejoren su producto.

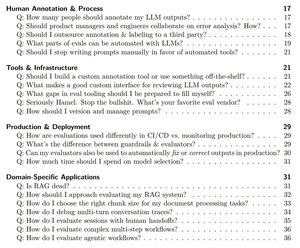

Después de capacitar a 2,000+ PM e ingenieros en 500+ empresas, han destilado su metodología en un libro de jugadas sistemático que le muestra exactamente cómo:

- Identifique los ~ 10 modos de falla que realmente rompen su producto

- Construya jueces de LLM que pueda validar estadísticamente y confiar

- Crear canalizaciones de CI/CD que detecten regresiones antes de que lo hagan los usuarios

- Convierta el monitoreo de la producción en un motor de descubrimiento para nuevos problemas

Lea su guía completa aquí:

Populares

Ranking

Favoritas