熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

大多數AI評估都是昂貴的謊言。

它們通常測量的是容易測量的東西——像“幻覺”和“毒性”這樣的指標——而不是你的產品實際如何讓用戶失望的具體方式。

@HamelHusain 和 @sh_reya 教授了一種不同的方法——這種方法使他們的課程成為 @MavenHQ 上收入最高的課程,@OpenAI、@AnthropicAI 和每個主要AI實驗室的註冊人數持續增長。

他們的見解:從錯誤分析開始,而不是指標。

審查100個真實用戶交互。詳細批評實際出錯的地方。尋找模式。只有這樣,才能構建出能讓你的產品更好的評估。

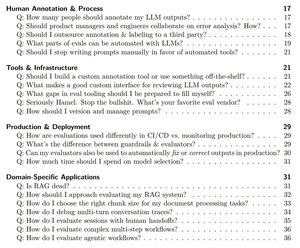

在500多家公司培訓了2000多名PM和工程師後,他們將他們的方法論提煉成一個系統化的手冊,準確展示如何:

- 識別大約10種實際破壞你產品的失敗模式

- 構建可以進行統計驗證和信任的LLM評判者

- 創建在用戶之前捕捉迴歸的CI/CD管道

- 將生產監控轉變為新問題的發現引擎

在這裡閱讀他們的完整指南:

熱門

排行

收藏