Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

När jag tränar multimodala omni foundation-modeller tycker jag alltid om att gå tillbaka till den första generalistagenten som släpptes av @scott_e_reed, @NandoDF och teamet på DeepMind, som släpptes före chatGPT i maj 2022.

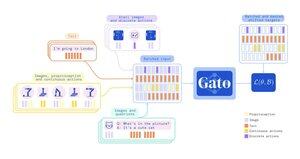

En 1,2B-modell, Gato, är inte bara multimodal, utan en generalistisk politik med flera uppgifter och flera förkroppsliganden.

"Den kan spela upp Atari, texta bilder, chatta, stapla block med en riktig robotarm och mycket mer, och bestämma baserat på sitt sammanhang om den ska mata ut text, ledmoment, knapptryckningar eller andra tokens."

Nando twittrade "Game over" efter denna release!

Topp

Rankning

Favoriter