Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Vi presenterar Liquid Nanos – en ny familj av extremt små uppgiftsspecifika ⚛️ modeller som levererar prestanda i GPT-4o-klassen samtidigt som de körs direkt på telefoner, bärbara datorer, bilar, inbyggda enheter och GPU:er med lägsta latens och snabbaste generationshastighet.

> modellstorlek: 350M till 2,6B

> byggd på LFM2, vår v2 effektiva modellarkitektur

> presterar konkurrenskraftigt med modeller som är upp till hundratals gånger större

> möjliggör grundläggande agentiska uppgifter: exakt dataextrahering, flerspråkig översättning, verktygsanrop, matematik och RAG. 1/n

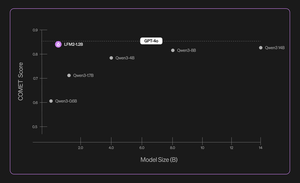

Vi använder en kombination av metoder för automatiserade utvärderingar, kunskapsdestillation, RL och modellsammanslagning för att iterativt förbättra en modells prestanda på en given uppgift. De resulterande modellerna, även om de är små, presterar konkurrenskraftigt jämfört med betydligt större modeller. 2/n

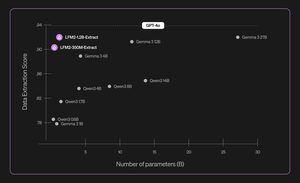

Till exempel är LFM2-350M-Extract och LFM2-1.2B-Extract utformade för att extrahera viktig information från en mängd olika ostrukturerade dokument (t.ex. artiklar, transkriptioner eller rapporter) till strukturerade utdata som JSON, XML eller YAML. De är kompatibla med engelska, arabiska, kinesiska, franska, tyska, japanska, koreanska, portugisiska och spanska.

Våra modeller för datautvinning ger en betydande ökning av validitet, noggrannhet och trohet. Till exempel kan LFM2-1.2B-Extract mata ut komplexa objekt på olika språk på en nivå som är högre än Gemma 3 27B, en modell som är 22,5 gånger så stor och som närmar sig sin prestanda till GPT-4o. 3/n

Vi presenterar sex uppgiftsspecifika Nanos i vår första version:

> LFM2-Extract – En 350M och 1.2B flerspråkig modell för dataextrahering från ostrukturerad text, som att omvandla fakturamejl till JSON-objekt.

> LFM2-350M-ENJP-MT – En 350M-modell för dubbelriktad engelsk ↔ japansk översättning.

> LFM2-1.2B-RAG – En 1.2B-modell som är optimerad för frågesvar med lång kontext i RAG-pipelines.

> LFM2-1.2B-Tool – En 1.2B-modell byggd för funktionsanrop och användning av agentverktyg.

> LFM2-350M-Math – En 350M resonemangsmodell för att lösa matematiska problem.

4/n

"Jag tycker att det är mycket imponerande att Liquids nya teknik före och efter träning gör det möjligt för deras snabba och små LLM:er att prestera i nivå med gränsmodeller som GPT-4o, som är storleksordningar större, på specialiserade uppgifter", säger Mikhail Parakhin (@MParakhin), CTO, Shopify. "Liquid höjer samtidigt ribban för både prestanda och hastighet i fundamentmodeller, och driver utvecklingen bortom den senaste tekniken. Det är därför vi är glada över att använda deras modeller på Shopifys plattformar och tjänster." 5/n

"Deloitte är glada över möjligheten att samarbeta med Liquid AI och deras nya Nanos-modell, som har potential att driva prestanda jämförbar med större modeller till en lägre kostnad", säger Ranjit Bawa (@ronbawa), Chief Strategy and Technology Officer, Deloitte U.S. 6/n

"Liquids Nanos representerar en kraftfull brytpunkt för AI-datorer och levererar prestanda på frontnivå i en kompakt, energieffektiv form. På AMD delar vi detta fokus på ledarskap med prestanda per watt och ser intelligens på enheten som nyckeln till att skala AI brett och hållbart, säger Mark Papermaster (@mpaper2000), CTO och EVP, AMD. 7/n

561,17K

Topp

Rankning

Favoriter