Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

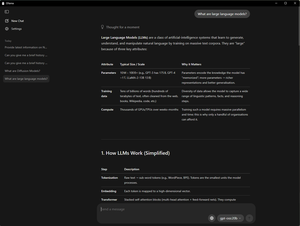

Rozpocznij uruchamianie LLM lokalnie z @Ollama—doświadcz poprawy wydajności na komputerach RTX AI działających na Gemma 3 i gpt-oss.

Przeciągnij. Upuść. Rozmawiaj. Powtarzaj. Dowiedz się więcej 👉

Najlepsze

Ranking

Ulubione